Le gouvernement a récemment lancé une réflexion sur l’identité numérique. J’ai depuis lu plusieurs articles sur la question, et notamment une interview de Mounir Mahjoubi, Secrétaire d’État au numérique dans l’Usine Digitale. Il est très positif que le gouvernent souhaite simplifier et inclure par le numérique. Cependant, quelques détails de cette tribune, comme l’intervention du Secrétaire d’État sur LCI me posent questions. Peut-être que ce sont des questions bêtes qui pourront rapidement trouver réponses…

Cette article doit être vu comme un questionnement citoyen ouvert ; un point de départ. Si vous avez des réponses, dites-le moi. Je serai heureux d’ajuster mon discours à la lumière de nouveaux éléments !

Sommaire :

Mes questionnements principaux partent du paragraphe suivant de l’Usine Nouvelle, concernant la question de « l’identité numérique » :

Où en êtes-vous ?

M. M. – On a lancé le groupe de configuration Ministère de l’intérieur/Dinsic. Ils ont commencé. Je leur ai demandé de travailler jusqu’au mois de février sur plusieurs scénarios : celui de la carte physique avec une puce, qui est le choix estonien ; et celui du 100% virtuel, comme ce que font la plupart des banques. Entre les deux, il y a d’autres dispositifs possibles. L’objectif est que face à chacun de ces scénarios, on puisse faire des tests avec des utilisateurs, faire l’analyse économique du coût pour l’État, de voir comment on peut le généraliser et à quelle vitesse. Nous devons être capables de décider avant fin 2018. Et déployer. Tant que ce n’est pas prêt, il y a FranceConnect. En parallèle, on déploie les autres briques.

Carte ou pas carte ?

Nota bene : cette question me semble plus accessoire que les suivantes. Elle est assez technique et n’apporte pas de repère conceptuel et architectural majeur. Si vous êtes pressé, je vous inviter à passer directement à la question suivante.

Cette question semble donc complètement ouverte pour le groupe de travail inter-ministériel. Celle-ci appelle d’autres sous-questions :

- Le texte de Carte Nationale d’Identité dite électronique, dont les décrets ont été promulgués dans les dernières semaines du quinquennat de Nicolas Sarkozy a été censuré par le Conseil Constitutionnel, qui n’acceptait pas l’usage de la puce du dispositif pour signer des documents électroniquement.

- Est-ce raisonnable de modifier la constitution pour surpasser ce point de blocage ?

- Quels ajustements techniques permettraient de surpasser ce problème, sachant que le projet de loi prévoyait déjà à l’époque deux compartiments distincts pour cette carte (une pour les usages régaliens, l’autre pour la vie quotidienne).

- Serait-il toujours intéressant de fournir une telle carte à puce si le citoyen ne peut que prouver son identité (s’identifier et s’authentifier) et non pas signer électroniquement des documents ?

- Une puce électronique avait été intégrée aux premiers permis de conduire au format européen par l’ANTS. Cette puce, qui permettait de vérifier l’authenticité du titre présenté, a été supprimée au bout d’un an pour des raisons budgétaires.

- Quel surcoût induiraient la fabrication et la distribution de telles cartes ?

- Quels risques et quels surcoûts pourrait induire la découverte a posteriori d’une faille de sécurité dans les titres émis (exemple du cas Estonien en 2017) ?

- Certaines villes, comme Angers, mettent à disposition une carte « de vie quotidienne » disposant de plusieurs compartiments étanches permettant de stocker des informations liées à plusieurs types d’usage. Quel est le coût de ces technologies ? Quelle est leur évolutivité ? Quel est le retour d’expérience de ces agglomérations ?

- Une carte physique « à tout faire » est-il réellement porteur de simplification ?

- Sur le plan logiciel, les cas d’usages d’une telle carte passent en grande partie par la saisie d’informations sur un navigateur web. Il n’existe à l’heure actuelle aucun standard stable et implémenté permettant d’utiliser facilement un dispositif de signature physique (telle une carte à puce) via un navigateur web. Il est nécessaire d’installer de complexes logiciels (middleware), hors de porté de nombreux citoyens, et d’autant plus complexe à utiliser dans un environnement mobile.

- Les pays ayant distribué de telles cartes depuis une dizaine d’années (Espagne, Belgique, etc.) observent-ils le développement d’usages réels au-delà de quelques cas d’usages marginaux ?

- L’achat d’un lecteur de carte nécessitera-t-il un dispositif de subvention sur condition de ressource complexe et couteux à gérer ?

- La fonction de signature électronique ne pourrait-elle pas être fournie par un autre moyen ?

- Ne serait-il pas possible d’adjoindre à l’État plateforme un composant de signature, permettant une gestion transparente des clés à la place du citoyen une fois celui-ci authentifié via FranceConnect ?

- Au-delà de fournir le moyen d’authentification au citoyen, cette brique ne pourrait-elle pas faciliter, via une API simple, l’intégration de la signature au sein des administrations et organismes publics (ou non) ?

- Pour les usages réclamant un plus fort niveau de sécurité (niveau eIDAS 2), ne pourrait-on pas mobiliser l’usage de la carte vitale ?

- Serait-il moins couteux d’ajuster le processus de délivrance de cette carte Vitale que d’en produire une nouvelle, pour atteindre une même valeur probante (niveau eIDAS 3) ? De même, d’autres possibilités techniques existe pour avoir une authentification de niveau 3 : l’usage du de la SIM mobile (Orange est déjà fournisseur d’identité FranceConnect) ou la reconnaissance faciale (cf expérimentation ANTS).

Réduire l’identification à un seul vecteur est-il souhaitable ?

L’interview de Mounir Mahjoubi dans L’usine digitale sous-entend, via la phrase « Tant que ce n’est pas prêt, il y a France Connect« , que cette future identité numérique sera unique et remplacera l’architecture FranceConnect. L’approche qui me semble proposée par le gouvernement est de résumer l’authentification à un seule et unique vecteur d’identification/authentification.

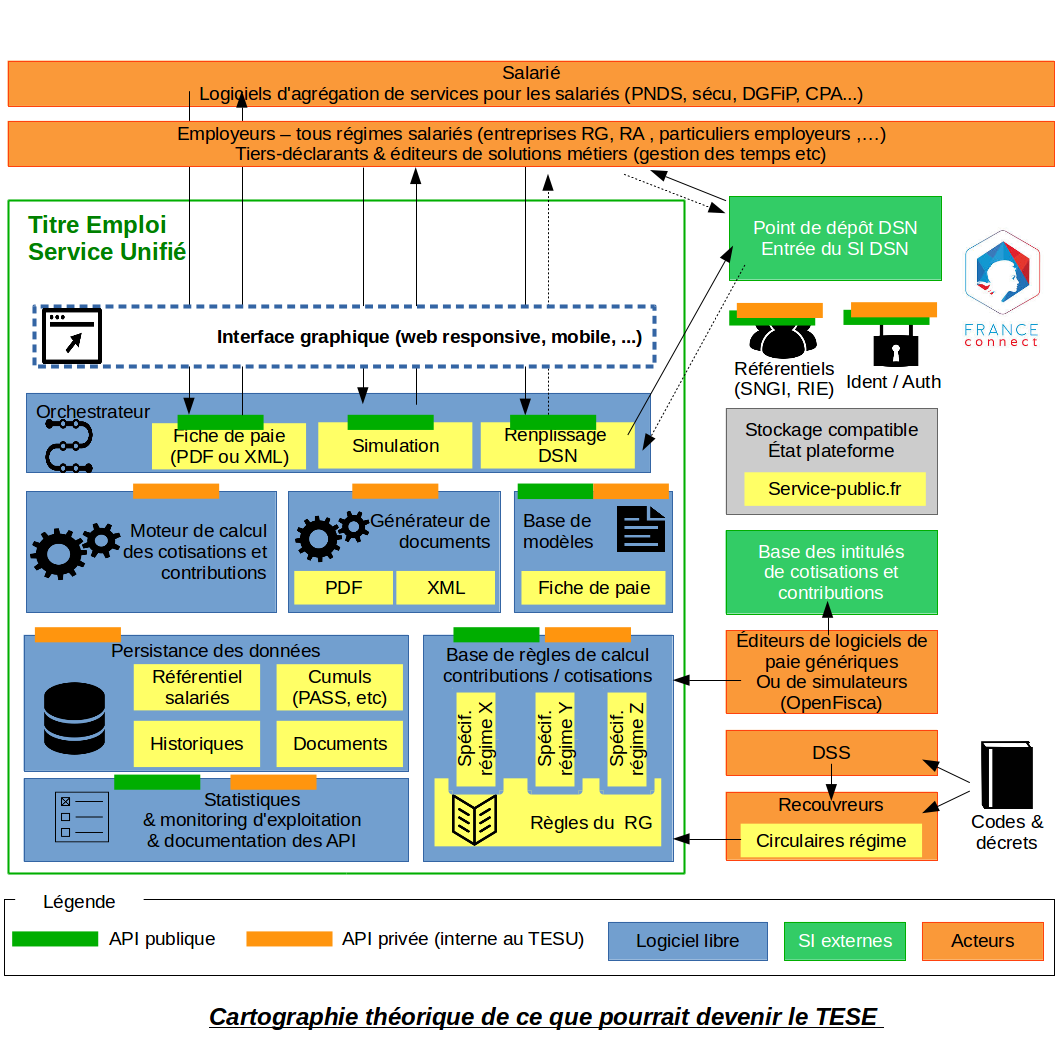

Dans un article précédent, j’ai expliqué pourquoi créer une base de données centralisatrice unique ne me paraissait ni pérenne, ni architecturalement pertinent pour simplifier durablement la vie des usagers. En effet, il est nécessaire que les administrations communiquent, dès lors que le citoyen l’accepte explicitement, les informations nécessaires à la réalisation des démarches administratives déjà connues. Cependant, une base centralisatrice ultime est une chimère étant donnée la vitesse d’évolution des organisations et des systèmes d’information. En revanche, apprendre aux organismes publics à concevoir des SI nativement ouverts sera beaucoup plus pérenne et évolutif.

L’absence de base de données unique n’interdit en aucun cas la création d’un portail agrégateur d’API se connectant en temps réel aux systèmes d’information des divers organismes (tel www.mesdroitssociaux.gouv.fr). Telle la base chimérique évoquée plus haut, le portail ne sera par nature jamais 100% complet. Cependant, avec cette architecture inter-opérable et décentralisée, l’incomplétude du portail « phare » ne limitera pas le développement de services complémentaires utilisant les API d’autres SI publics.

De la même manière, j’ai des doutes sur la pérennité d’une identité numérique unique. Créer une « nouvelle identité », qu’elle soit virtuelle ou matérialisée une carte physique, peut être une bonne chose. Cependant, je pense qu’elle devrait s’inscrire dans l’architecture de fédération d’identités FranceConnect actuelle permettant par nature la gestion de plusieurs vecteurs d’identification et d’authentification. Ainsi cette « nouvelle identité » serait un Fournisseur d’Identité FranceConnect supplémentaire, et ne remplacerait en aucun cas l’infrastructure FranceConnect en tant que telle :

- Tous les usages ne nécessitent pas le même niveau d’authentification. Plus un procédé d’authentification est sécurisé, plus il est contraignant pour l’usager. Aussi, il me parait dommage de ne pas pouvoir adapter le niveau d’authentification demandé par un fournisseur de service à la sensibilité des services qu’il propose. Cette souplesse est aujourd’hui permise par FranceConnect.

- Tous les usagers ne seront pas forcément éligibles à cette nouvelle identité, ou ne souhaiteront pas forcément y souscrire. De même, la perte de ce facteur d’authentification pourrait priver l’usager de services en ligne. Conserver une architecture telle que FranceConnect (reposant sur le standard OpenIDConnect) permettra à l’usager d’utiliser une autre identité en cas de perte du vecteur d’identité qu’il utilise habituellement.

- Le règlement Européen eIDAS impose que chaque citoyen puisse s’authentifier sur les services publics des États de l’UE via un vecteur d’authentification émis par son pays d’origine. L’architecture FranceConnect permettra l’intégration de ces ressortissants communautaires de manière transparente pour les fournisseurs de service. Permettre un usage de la nouvelle identité numérique du gouvernement sans passer par FranceConnect conduira donc à traiter les ressortissants comme des populations de seconde zone, ce qui est contraire à l’esprit eIDAS.

- FranceConnect a été créé suite à l’échec de l’identité unique mon.service-public.fr. Les chiffres de recrutement montraient que les citoyens préféraient utiliser les comptes qu’ils possédaient déjà auprès de tiers de confiance publics tels que l’Assurance Maladie ou la DGFiP que de créer un nouveau compte « à tout faire ».

L’architecture FranceConnect repose sur des standards du web techniquement simples à mettre en œuvre. La création de cette nouvelle identité numérique ne doit pas permettre aux entités publiques de s’affranchir de cette intégration, sans quoi cela reviendrait à tuer, de fait, le principe de fédération.

L’infrastructure pour décloisonner les administrations n’existe-t-elle pas déjà ?

Plus que l’unicité du vecteur d’authentification, ce qui importe pour l’usager est de ne pas avoir à fournir d’informations ou de pièces justificatives qui seraient déjà en possession d’un organisme public (ou privé réglementé), suivant le principe du Dites-le nous une fois. Le sujet n’est pas le stockage de la donnée, mais sa propension à circuler de manière rapide. Autre point majeur, rappelé par Mounir Mahjoubi à l’Usine Digitale, la protection des données personnelles des usagers. Celui-ci doit donc pouvoir :

- Techniquement, autoriser explicitement une administration à fournir une autre administration une donnée le concernant, dans un but précis (correspondant à ce que la CNIL appelle la « finalité du traitement »). Il s’agit là de l’application du principe d’auto-détermination informationnelle soutenu par le Conseil National du Numérique en 2015.

- Cette autorisation doit pouvoir être donnée en temps réel afin d’éviter les longs délais réglementaires préalables à l’établissement d’un flux d’échange bilatéral entre deux administrations.

- De même, le citoyen doit pouvoir vérifier a posteriori la nature des données (pas forcément les données elles-mêmes) échangées entre deux administrations.

Bonne nouvelle, toutes ces contraintes sont déjà respectées par FranceConnect ! En effet, si la presse a préféré décrire FranceConnect comme un simple moyen d’authentification, ce composant est avant tout précieux, car il organise la transmission à la volée d’information de manière décentralisée !

Enfin, lorsque Mounir Mahjoubi annonce sur LCI que cette nouvelle identité numérique permettra de se connecter sur le site de « la sécurité sociale », des impôts, de Pôle Emploi, de la CAF avec un seul mot de passe. Là aussi, FranceConnect le permet déjà techniquement. Le problème est ici politique. Les acteurs ne jouent pas complètement le jeu, et leurs tutelles ne les ont pas contraint jusqu’ici. Il est ainsi regrettable que le bouton FranceConnect ne soit présent sur ameli.fr, alors que ce site permet justement l’identification des citoyens via FranceConnect depuis d’autres sites (ce sont des Fournisseurs d’identité) ! Il est ainsi possible de s’authentifier sur se site de l’assurance-retraite avec son compte DGFiP ou Ameli, mais pas de se connecter à son compte Ameli à partir de son compte DGFiP ! Le bouton FranceConnect venant tout juste d’apparaitre sur impots.gouv.fr, gageons qu’il arrivera bientôt sur Ameli.fr

Peut-être que mon raisonnement fait fi d’un argument important justifiant une remise en cause de FranceConnect. Dites-le moi si c’est le cas !

Le plus important n’est-il pas d’encourager le raccordement des organismes publics à l’infrastructure d’échange existante plutôt que de casser la dynamique de montée en charge avec un chamboulement d’architecture ?

Les grosses organisations, publiques comme privées, ont une inertie qui nécessite de nombreux efforts et beaucoup de temps pour produire des résultats. Ainsi, une relative stabilité des protocoles et des standards me semble nécessaire pour que ceux-ci soient mis en œuvre dans les administrations et les territoires. Dans la mesure où FranceConnect mobilise des standards ouverts, les éditeurs de logiciel métier ont pu les intégrer relativement rapidement. Ainsi, le compte Twitter de la DINSIC (@_FranceConnect_) affiche depuis quelques semaines l’entrée en production d’un fournisseur de service chaque jour !

D’autre part, la marque FranceConnect est de plus en plus connue par les citoyens, qui l’utilisent sur les portails de grands opérateurs tels que le GIP Union-Retraite, la CNAV, ou encore l’ANTS.

La mayonnaise est donc en train de prendre. Il me semble nécessaire de poursuivre dans cette direction, mais d’accélérer les efforts de pédagogie auprès des fournisseurs de données et de services qui n’identifient pas encore suffisamment l’importance et l’urgence d’ouvrir leur SI via des API à l’état de l’art, en accès et modification, en temps réel et en aucun cas limité à des accords bilatéraux avec des consommateurs pré-définis.

Changer l’architecture maintenant apporterait peut-être en termes de communication au gouvernement, mais ne me parait pas judicieux. L’attentisme qui en découlera et l’énergie qui devra être mobilisée pour migrer retarderaient d’autant la vraie modernisation ; c’est à dire l’ouverture des SI sur tout le territoire.

Trois exemples d’accélérations à mener

Parmi les exemples les plus flagrants, FICOBA. À ma connaissance, ce ficher, regroupant l’ensemble des numéros de comptes bancaires ouverts auprès d’établissements français, n’est pas accessible via FranceConnect. Ainsi, l’accès à ces données est encore soumis à une liste de destinataires limitée par décrets, alors que FranceConnect permettrait à chacun d’autoriser (ou non) en temps réel l’accès à ces données par une administration tierce. De plus, les administrations n’ayant pas un accès temps réel à cette base de données, elles développent de complexes outillages pour sécuriser la modification en ligne des RIB/IBAN par leurs usagers. L’APIsation de FICOBA et son intégration à FranceConnect permettraient aux usagers de simplement sélectionner le compte bancaire voulu parmi la liste des comptes enregistrés dans FICOBA, sans ressaisie, sans risque d’erreur, et avec validation du statut du compte.

Autre exemple : il me semble indispensable d’ajouter à l’agrégateur APIparticulier une fonctionnalité de récupération des justificatifs, produits par des entreprises de secteurs réglementés (justificatif de domicile ou d’assurance par exemple).

Enfin, l’implémentation par tous les établissements d’enseignement supérieur d’une API permettant de vérifier les diplômes effectivement obtenus permettrait de limiter les fraudes et de fluidifier l’inscription aux concours de la fonction publique. L’implémentation de cette API par des acteurs tels que l’AMUE, l’Association Cocktail et le Ministère de l’Éducation Nationale permettrait dans un premier temps de couvrir une part significative des diplômés.

En somme, je pense que pour atteindre l’objectif de décloisonnement du gouvernement, il est avant tout nécessaire d’inciter, voire de contraindre, les administration à ouvrir leurs SI rapidement. Pour se faire, il est urgent de travailler avec elles à la construction des scopes de données FranceConnect et d’alimenter les hub d’API tels que APIParticulier ou APIEntreprise.

Pour de plus amples réflexions sur les extensions possibles de FranceConnect et de l’État plateforme, je vous propose de lire cet article.